Tag: SEO

Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im Internet an, das frühe Web zu sortieren. Die Seitenbesitzer erkannten flott den Wert einer bevorzugten Listung in den Ergebnissen und recht bald entstanden Einrichtung, die sich auf die Optimierung professionellen.

In Anfängen bis zu diesem Zeitpunkt die Aufnahme oft zu der Übermittlung der URL der richtigen Seite an die vielfältigen Suchmaschinen im Internet. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webseite auf den Web Server der Suchseiten, wo ein 2. Anwendung, der gern genutzte Indexer, Angaben herauslas und katalogisierte (genannte Wörter, Links zu ähnlichen Seiten).

Die damaligen Typen der Suchalgorithmen basierten auf Informationen, die mit den Webmaster eigenhändig vorhanden werden konnten, wie Meta-Elemente, oder durch Indexdateien in Internet Suchmaschinen wie ALIWEB. Meta-Elemente geben einen Gesamtüberblick per Gehalt einer Seite, doch setzte sich bald heraus, dass die Benutzung der Hinweise nicht verlässlich war, da die Wahl der angewendeten Schlüsselworte dank dem Webmaster eine ungenaue Beschreibung des Seiteninhalts spiegeln konnte. Ungenaue und unvollständige Daten in den Meta-Elementen vermochten so irrelevante Seiten bei besonderen Benötigen listen.[2] Auch versuchten Seitenersteller diverse Merkmale in einem Zeitraum des HTML-Codes einer Seite so zu lenken, dass die Seite überlegen in Ergebnissen gefunden wird.[3]

Da die frühen Suchmaschinen im Netz sehr auf Merkmalen abhängig waren, die allein in Händen der Webmaster lagen, waren sie auch sehr vulnerabel für Straftat und Manipulationen in der Positionierung. Um tolle und relevantere Vergleichsergebnisse in Serps zu erhalten, musste ich sich die Operatoren der Suchmaschinen im Internet an diese Faktoren einstellen. Weil der Erfolg einer Suchseite davon anhängig ist, besondere Ergebnisse der Suchmaschine zu den gestellten Keywords anzuzeigen, vermochten unangebrachte Testurteile dazu führen, dass sich die Nutzer nach diversen Varianten für den Bereich Suche im Web umschauen. Die Erwiderung der Suchmaschinen vorrat in komplexeren Algorithmen beim Positionierung, die Punkte beinhalteten, die von Webmastern nicht oder nur nicht gerade leicht lenkbar waren. Larry Page und Sergey Brin entwarfen mit „Backrub“ – dem Urahn von Suchmaschinen – eine Search Engine, die auf einem mathematischen KI basierte, der anhand der Verlinkungsstruktur Webseiten gewichtete und dies in den Rankingalgorithmus eingehen ließ. Auch zusätzliche Search Engines orientiert bei Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein.

Nachricht: How Lengthy Does search engine marketing Take to Work For a New Website?

Nachricht: Get Excessive High quality Traffic To Web site In 2021 Web site Site visitors Hacks search engine marketing Tips Simplilearn

Nachricht: How I made €100,000 with web optimization in 2020

How To: English Google website positioning office-hours from April 29, 2022

search engine optimization Tutorial for Learners – Step by Step Information 2021! (+YOAST website positioning)

Meldung: Website positioning In Guk (서인국) ‘Damaged’ Music Video Making Film (브로큰)

Meldung: CSW – We make IT simple | IT Services | Internet Design | website positioning service from Hamm

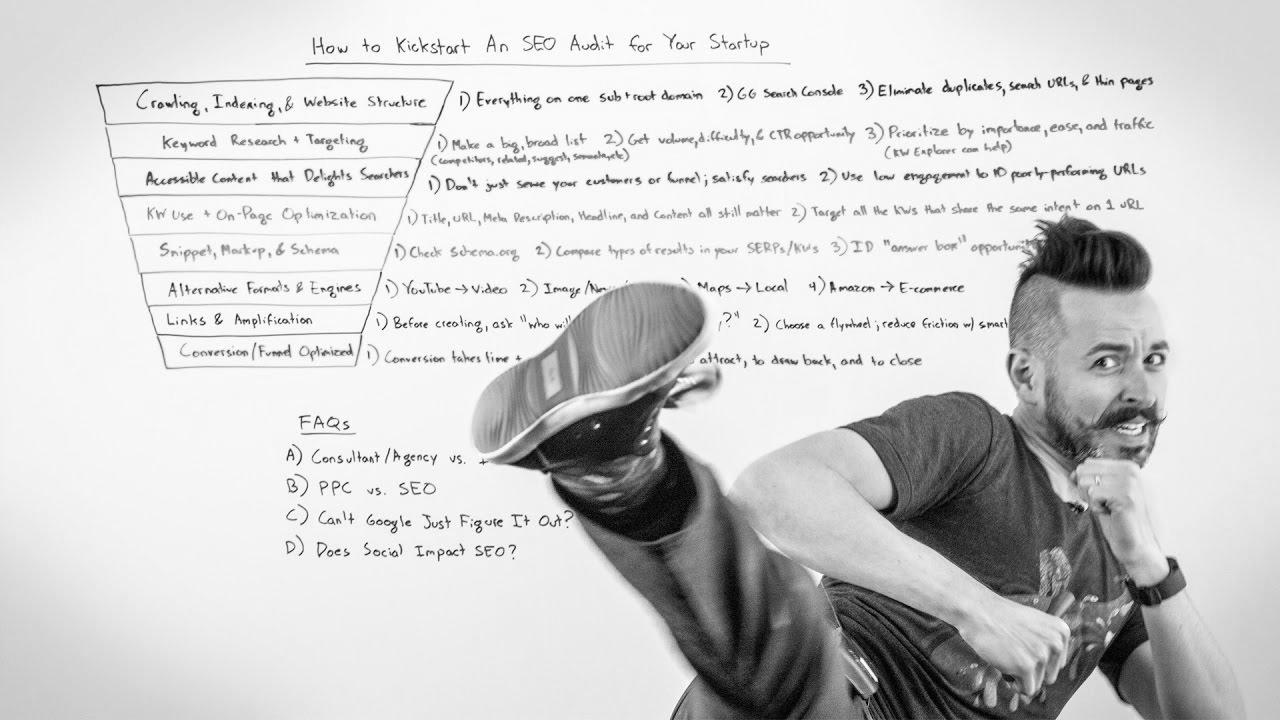

Mehr zu: On Web page website positioning Checklist for Increased Google Rankings

![【BTS】Cheon {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS] 【BTS】Cheon {Seo|Search engine optimization|Web optimization|Search engine marketing|Search engine optimisation|Website positioning} Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS]](/wp-content/uploads/2022/07/1657168940_maxresdefault.jpg)

How To: 【BTS】Cheon Seo Jin and her harem 😂 | THE PENTHOUSE 2 [ENG SUBS]